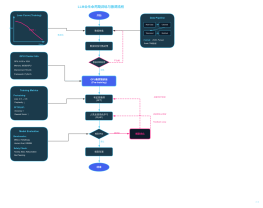

解决大模型的安全问题

(AI 对抗AI的建设思路)

大模型训练阶段

训练数据安全

对训练数据进行脱敏、去毒,包括个人隐私信息、违规内容等

大模型部署阶段

自动化红队测试

沉淀了 10W+ 的恶意样本对大模型应用进行安全评估

模拟攻击:用另一个攻击性模型(Attacker LLM)疯狂攻击你的模型,试图套出违规内容

安全基准评测(Benchmarks)

建立一套考卷,计算拒答率(该拒绝的拒绝了吗?)和误杀率(不该拒绝的拒绝了吗?)

平衡性:安全不能牺牲太多可用性。如果模型什么都回答“我不知道”,那它就没用了

控制与授权

应用阶段

内容安全防护体系

语义向量防火墙

部署向量数据库(如 Milvus/Chroma),存入已知攻击案例(如“奶奶漏洞”、“DAN模式”)。用户提问时,计算语义相似度,相似度 > 0.85 直接拦截

用户Prompt识别

实时对用户的 Prompt 输入进行检测,通过敏感词加小模型加大模型叠加的方式,实时检测违规内容及提示词注入风险

模型生成内容识别

基于大模型生成内容进行实时检测,防止违规内容漏出。

内容风控引擎

模型管理

策略管理

词库管理

举报处置

运营阶段

策略运营 —— 核心是“不误杀、不漏判”

(这是业务方最在意的点。如果你的安全盾把正常用户的请求拦截了(误杀),业务方会投诉你影响了他们的 DAU;如果你没拦住违规内容(漏判),业务方出事了会让你“背锅”。

)

误杀率(False Positive)治理

痛点: 比如业务方是写小说的,用户输入“杀人”,被你的安全盾拦截了,这就是严重的误杀。

解法:分级策略模板:不要“一刀切”。提供 [严格 / 标准 / 宽松] 三套模板给不同业务

漏判(False Negative)与攻防演练

痛点:新的越狱指令(如“DAN 模式”、“摩斯密码注入”)层出不穷

解法:

攻击样本库更新: 每周收集外部最新的 Prompt 攻击手法,加入回归测试集。

专项治理: 针对特定垂直领域(如金融的荐股合规、医疗的药方合规)定制专用词库。

服务运营 —— 核心是“低延迟、易接入”

(安全防护是业务链路中的“阻碍”(增加延迟,可能报错)。运营的目标是降低业务方的接入阻力和心理负担。

)

SLA 稳定性监控

关注指标: P99 延迟(Security Latency)。

建立“降级熔断”机制:当安全服务挂了,是“全部拦截(Fail-closed)”还是“全部放行(Fail-open)”?这需要和业务方提前谈好运营协议

接入体验与自助化

痛点:业务方不懂什么是“Prompt 注入”,不知道怎么配

可视化配置后台: 让他们能像配防火墙规则一样开关策略(例如:开启涉政过滤,关闭竞品拦截)。

沙箱测试环境: 提供一个 Playground,业务方接入前可以先拿几个 Prompt 跑一下,看看你们的拦截效果。

价值运营—— 核心是“自证清白、体现价值”

(安全通常是“隐形”的,不出事没人觉得你重要,一出事就是你的错。你需要通过数据显性化你的价值。)

安全拦截周报/月报

目标: 告诉业务方老大:“这个月我帮你们挡了多少次攻击,帮你们省了多少麻烦。”

报表内容:

总拦截次数:12,000 次。

拦截类别分布:涉政 (30%)、竞品攻击 (20%)、恶意注入 (10%)。

Token 节省估算: 拦截了恶意请求,相当于帮业务方省了这些无效请求的大模型推理费(FinOps 价值)。

合规背书与审计

目标: 帮业务方搞定监管。

当业务方需要去网信办备案时,你们直接提供**《安全评估报告》和《算法备案材料包》**,极大降低他们的合规成本

应急响应运营—— 核心是“灭火速度”

(当出现 0-day 漏洞或突发舆情时,考验运营的敏捷度。

)

热修补(Hotfix)流程

场景: 某天突然全网流行一种新的“奶奶漏洞”。

运营必须具备不依赖发版,5 分钟内生效的能力。通过后台配置“临时正则规则”或“语义拦截补丁”,在这个漏洞蔓延之前堵住。

红蓝对抗演练 (Red Teaming)

定期(每月)组织内部的红队测试,甚至可以举办“内部赏金猎人赛”,鼓励公司内部员工攻击你们的防护系统,发现一个漏洞奖 500 元。这既是测试,也是最好的内部品牌宣传。

舆情监控

防止模型生成歧视、错误言论被截图发到社交媒体引发公关危机

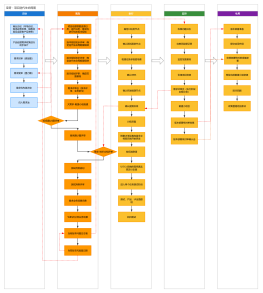

大模型安全防护落地路线图(Roadmap)

阶段一:防守基线 (MVP) —— 止血与合规<br>(建立最基础的拦截网,防止低级攻击和明显违规,确保应用能过“备案”或基本合规审查)

输入端 (Input)

关键词黑名单: 建立基于正则(Regex)的敏感词库(涉政、黄赌毒、竞品词)。

Prompt 长度限制: 限制 Token 数量,防止 DoS 攻击。

系统指令 (System Prompt) 固化: 在 Prompt 中明确写入“安全三原则”(不违法、不歧视、不泄密)

输出端 (Output)

API 级审核: 接入云端安全能力审核 API(如百度、象信、火山)。

数据隐私

PII 基础脱敏: 使用正则匹配手机号、身份证、邮箱,在发送给 LLM 前替换为 [PHONE_NUMBER]

人审

定位: 兜底与合规交代。为了过备案,必须展示你有“人工干预机制”

搭建一个最简陋的后台,允许运营人员查看被拦截的日志。

处理用户的误杀申诉(这是 MVP 阶段最重要的人审工作,防止业务方骂你)。

交付物

敏感词库 v1.0

兜底回复机制(如:“抱歉,我无法回答该类问题”)。

所有的 Prompt 输入输出日志存储(用于后续审计)。

阶段二:语义增强 (V1.0) —— 防绕过与上下文安全<br>( 解决“关键词防不住”的隐晦攻击)

输入端 (Input)

语义向量防火墙: 部署向量数据库(如 Milvus/Chroma),存入已知攻击案例(如“奶奶漏洞”、“DAN模式”)。用户提问时,计算语义相似度,相似度 > 0.85 直接拦截

输出端 (Output)

流式审核:搭建滑动窗口检测机制,在打字机效果输出的同时进行审核,发现违规立即截断

人审&AI

形式: 置信度分流

定位: 处理机器“拿不准”的 Case。

逻辑升级: AI 判分 >0.9 直接拦,<0.2 直接过,0.2-0.9 之间的推送到人审工作台。<br>工具建设: 此时必须给业务方交付一个好用的“审核后台”,支持批量通过/拒绝。

交付物

向量化黑名单机制

降低误杀率(False Positive)的白名单机制

阶段三:模型内生与自动化 (V2.0) —— 主动防御与红蓝对抗<br>(降低对外部 API 的依赖(降本),让模型自己变强,并建立自动化测试流程)

模型层 (Model)

私有化审核模型: 部署本地安全模型,替换付费的审核 API,实现数据不出域且成本可控

SFT 安全对齐:微调业务模型

测试与对抗 (Red Teaming)

自动化红队测试: 开发集成测试工具。每次模型或 Prompt 更新前,自动运行数千次攻击测试

对抗样本库: 将过去拦截到的真实用户攻击存入库中,作为回归测试集

人审

形式: SFT 数据标注 + 红队演练 (Red Teaming)。

定位: 数据生产工厂。人不再直接审业务数据,而是审“训练数据”。<br>

标注: 人工编写高质量的“拒答话术”,喂给模型训练。<br>攻击: 组织内部人员攻击 AI,发现漏洞后,人工打标修复,形成闭环

安全基准评测(Benchmarks)

建立一套考卷,计算拒答率(该拒绝的拒绝了吗?)和误杀率(不该拒绝的拒绝了吗?)

平衡性:安全不能牺牲太多可用性。如果模型什么都回答“我不知道”,那它就没用了

交付物

本地部署的高性能审核模型

自动化安全评估报告(每次上线前自动生成)

专门针对业务场景(如小滴助手、ESE)的定制化安全策略

阶段四:全面治理 (V3.0) —— 监控与审计<br>(可观测性、合规审计、用户体验)

全链路可观测性: 建立大屏监控,实时监测“拦截率”、“触发违规Top类别”、“越狱尝试次数”。

舆情与反馈闭环: 增加用户“点踩(Thumbs down)”反馈机制,将用户的负面反馈自动送入人工审核队列,反哺优化规则

人审

形式: 策略运营 + 合规审计员。

定位: 裁判员

不再看具体的 Case,而是看 Dashboard(大盘数据)。

调整尺度(例如:最近监管严,人工下发指令调高拦截阈值)。

定期输出合规报告给监管部门。

全生命周期防护

大模型防护架构

技术框架发展趋势

从单一防护到全生命周期安全:大模型安全框架正从单一的防护措施向覆盖数据、训练、部署、应用全生命周期的安全体系演进

从通用框架到垂直领域定制:安全框架正向政务、金融、医疗等垂直领域定制化发展,如奇安信的政务大模型安全治理框架

评估与防护并重:安全评估框架(如SafeBench)与防护框架协同发展,形成"检测-防护-评估"的闭环

安全与性能平衡:安全框架更加注重在保障安全的同时,尽量减少对模型性能的影响

安全理念发展趋势

安全与效率的平衡:未来的安全框架将更加注重在保障安全的同时,提高模型的运行效率

可解释性增强:安全框架将提供更多的可解释性功能,帮助用户理解安全决策的依据

自动化安全响应:实现自动化安全监测和响应,减少人工干预

跨模态安全防护:针对多模态大模型的安全防护技术将得到发展

政策与标准建议

建立统一的安全评估标准:制定大模型安全评估的统一标准和方法

推动安全框架开源共享:鼓励企业和研究机构开源其安全框架,促进技术交流和创新

加强国际合作:推动国际间在大模型安全领域的合作,共同应对全球性安全挑战

完善法律法规:建立健全与大模型安全相关的法律法规,明确各方责任和义务

大模型的开发者和使用者,建议

采用多层次的安全防护策略,结合多种安全框架和技术

定期进行安全评估和测试,及时发现和修复安全漏洞

加强安全监控和应急响应能力,确保在安全事件发生时能够快速响应

重视安全人才培养,提升团队的安全意识和技术能力